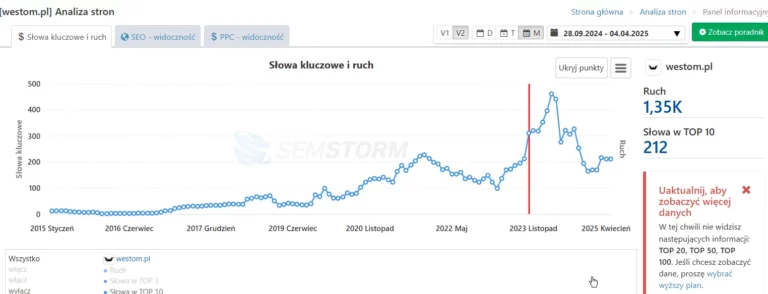

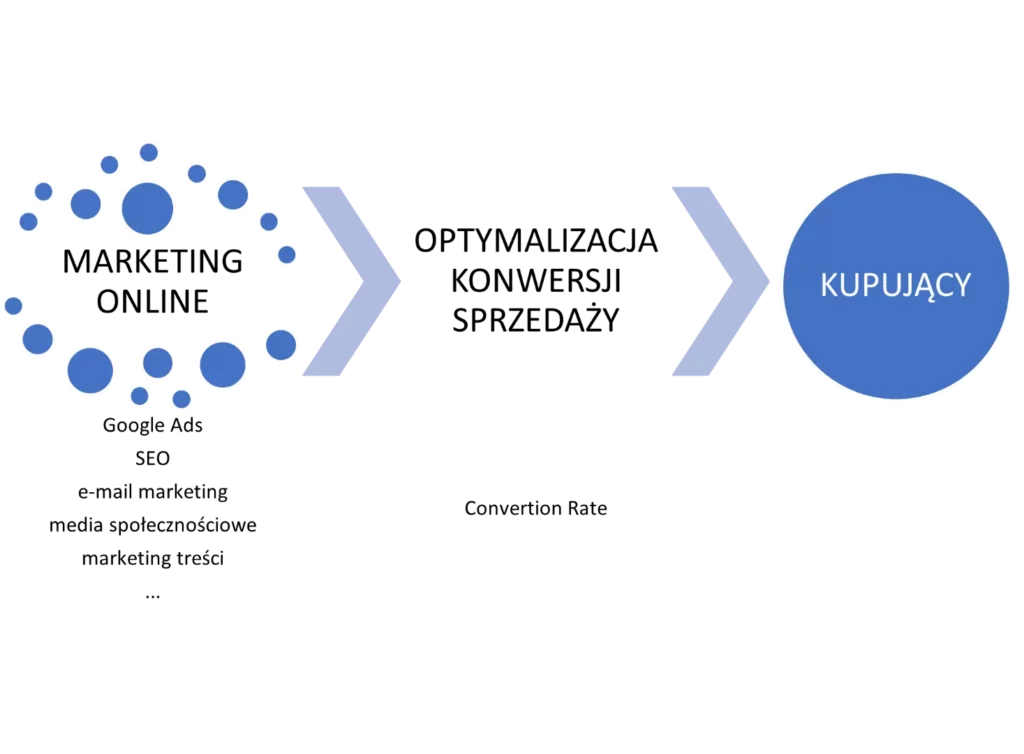

W sprzedaży online liczy się każdy procent konwersji. Nawet drobne usprawnienia w wyglądzie strony czy procesie zakupowym mogą przełożyć się na znaczący wzrost sprzedaży i obniżenie kosztu pozyskania klienta (CAC). Istnieją branże, które balansują na linie i próbują wyrwać ze sprzedaży każdy grosz. Taka walka o każdą złotówkę panuje szczególnie w branżach o niskiej marżowości na produktach oraz tam, gdzie jest bardzo wysoka konkurencja. Przykładem może być branża elektroniczna, gdzie te efekty (niska marża i wysoka konkurencja) kumulują się nawzajem.

Jedną z najbardziej efektywnych metod optymalizacji jest testowanie A/B. Pozwala ono w sposób naukowy (oparty na danych statystycznych) porównywać różne warianty elementów witryny i ustalać, który z nich lepiej działa na odbiorców.

Testy A/B są wykorzystywane zarówno przez gigantyczne platformy e-commerce, jak i małe sklepy internetowe. Ich popularność wynika z faktu, że dają konkretne dane o zachowaniach użytkowników w rzeczywistych warunkach, bez konieczności polegania wyłącznie na domysłach czy subiektywnych opiniach zespołu.

W niniejszym artykule pokażemy Ci krok po kroku, jak przeprowadzać testy A/B w sklepie internetowym, jakie obszary warto testować, jakie narzędzia wykorzystać oraz jak interpretować wyniki, aby skutecznie zwiększyć konwersję, poprawić użyteczność i w efekcie – zwiększyć zyski.

Co to są testy A/B?

Test A/B (zwany też split testem) to metoda, w której porównujemy dwie wersje (warianty) tego samego elementu strony (np. przycisku, nagłówka, układu koszyka) w tym samym czasie. Ruch użytkowników jest losowo dzielony między wariant A i wariant B. Po zebrania wystarczającej ilości danych, oceniamy, który wariant osiąga lepsze wyniki (np. wyższy wskaźnik konwersji).

Zaletą testów A/B jest ich prostota: jedna zmiana, dwie wersje, jasny wynik. Jeśli wariant B radzi sobie lepiej niż A z istotną różnicą statystyczną, to oznacza, że warto wdrożyć nowy pomysł na stałe. Taka metodologia zmniejsza ryzyko wprowadzania rozwiązań „na czuja” i pozwala opierać decyzje o ulepszeniach na faktycznych zachowaniach klientów.

Dlaczego testy A/B są ważne w sklepie internetowym

- Wzrost konwersji i sprzedaży: Czasem drobna zmiana – np. koloru przycisku „Dodaj do koszyka” – może przełożyć się na zauważalny wzrost liczby transakcji.

- Optymalizacja doświadczenia użytkownika (UX): Poprzez testy dowiesz się, jakie rozwiązania są najbardziej intuicyjne i przyjazne dla odwiedzających, co pomaga budować długotrwałe relacje z klientami.

- Mniejsze ryzyko zmian: Zamiast wdrażać obszerne redesigny strony oparte wyłącznie na subiektywnych opiniach, testujesz je w małej skali, eliminując błędy i straty w konwersji.

- Obiektywne dane: Wyniki testów A/B zwykle trudno jest podważyć – to twarde dane pokazujące, co działa, a co nie, w kontekście Twoich klientów.

Planowanie testów A/B – krok po kroku

Żeby testy przyniosły oczekiwane rezultaty, muszą być prowadzone w sposób uporządkowany i przemyślany. Oto najważniejsze etapy:

1. Wyznacz cel testu i kluczowy wskaźnik sukcesu

Zanim rozpoczniesz testowanie, sprecyzuj, co chcesz poprawić. Przykładowe cele to:

- Zwiększenie współczynnika konwersji (np. z 2% do 2,5%),

- Zmniejszenie porzuceń koszyka (np. z 65% do 60%),

- Wydłużenie średniego czasu spędzanego na stronie o X sekund,

- Podniesienie średniej wartości zamówienia (AOV) o 10%.

Dzięki temu łatwiej będzie wybrać wskaźnik, który mierzysz (tzw. KPI – Key Performance Indicator), np. konwersja, CTR (klikalność w przycisk), liczba wyświetleń strony, etc. W kontekście e-commerce najczęściej chodzi o konwersję (zakup) lub elementy, które się na nią przekładają (dodanie do koszyka, przejście do kasy).

2. Zbadaj obecną sytuację i zidentyfikuj potencjalne problemy

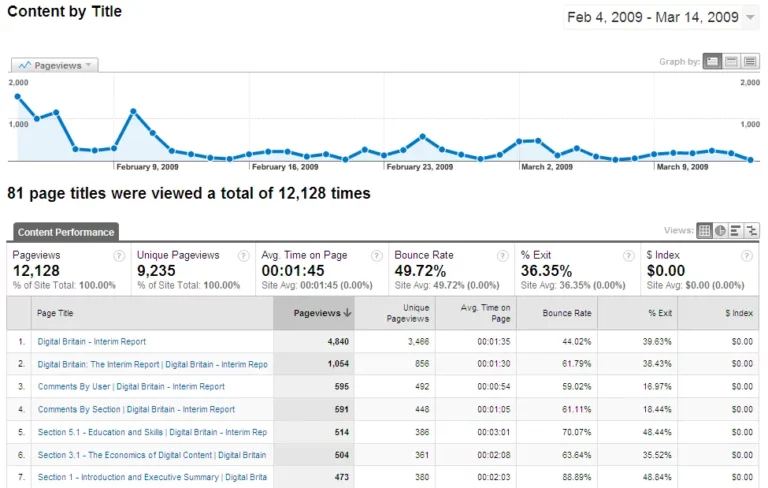

Analiza ruchu w sklepie internetowym pomoże Ci wskazać, gdzie najczęściej klienci rezygnują i co można ulepszyć. Obejrzyj dane z Google Analytics (lub GA4), mapy ciepła (Hotjar), wewnętrzną wyszukiwarkę, by zrozumieć zachowania użytkowników.

Przykład: Jeśli widzisz, że wiele osób dodaje produkty do koszyka, ale finalnie nie przechodzi do płatności, możesz przetestować zmiany w procesie checkoutu, np. usunięcie zbędnych pól formularza czy lepsze informowanie o czasie dostawy.

3. Opracuj hipotezę

Zastanów się, dlaczego w danym miejscu mogą występować problemy z konwersją i sformułuj hipotezę:

- „Zmiana koloru przycisku CTA na bardziej kontrastowy zwiększy klikalność, ponieważ przycisk będzie wyraźniej zauważalny”.

- „Skrócenie formularza dostawy do jednego kroku zmniejszy liczbę porzuceń koszyka, bo klienci szybciej sfinalizują zakup”.

Ważne, by hipoteza była możliwie prosta i zrozumiała. W testach A/B porównujesz zwykle jedną kluczową zmianę (lub niewielki zestaw powiązanych zmian) – testowanie wielu aspektów naraz może utrudnić interpretację wyników.

4. Przygotuj warianty A i B

- Wariant A (kontrolny) to aktualna wersja elementu strony.

- Wariant B (eksperymentalny) to nowa wersja, uwzględniająca zmiany.

Przykładowe zmiany, które możesz wprowadzić:

- Kolor, treść i pozycja przycisku,

- Tytuł i podtytuł na stronie głównej,

- Układ koszyka: jedna strona vs. wieloetapowy checkout,

- Różne grafiki i nagłówki w banerze promocyjnym,

- Inne układy karty produktu (np. przeniesienie kluczowych informacji o dostawie na górę).

5. Wybierz narzędzia do testów

Istnieje wiele platform i wtyczek ułatwiających testowanie A/B w e-commerce. Najbardziej znane to:

- Optimizely,

- VWO (Visual Website Optimizer),

- Adobe Target,

- AB Tasty.

Za ich pomocą łatwo wdrożysz wariant B na swojej stronie (bez konieczności robienia skomplikowanych zmian kodu) i automatycznie podzielisz ruch użytkowników między dwie wersje.

6. Ustal wielkość próby i czas trwania testu

Aby wyniki były statystycznie istotne, musisz zapewnić odpowiednią liczbę użytkowników w każdym wariancie testu. Wspierają w tym kalkulatory online, np. „A/B Test Sample Size Calculator” (od VWO czy AB Tasty), gdzie wprowadzasz:

- Obecny poziom konwersji,

- Zakładaną poprawę (efekt, którego się spodziewasz),

- Poziom ufności statystycznej (zazwyczaj 95%).

Przykład liczbowy: Jeśli Twój sklep ma konwersję 2% i chcesz wykryć wzrost do 2,4% (poprawa o 20% względem stanu początkowego) przy poziomie ufności 95%, kalkulator może Ci wskazać, że potrzebujesz np. 20 tys. odsłon lub 10 tys. unikalnych użytkowników na każdą z wersji. Jeśli dziennie odwiedza Cię 2000 użytkowników, test może trwać około 10 dni.

Nie kończ testu zbyt wcześnie – zanim osiągniesz wystarczającą próbę, wahania konwersji mogą być przypadkowe. Wyjątkiem jest sytuacja, gdy jedna z wersji wykazuje skrajnie słabe wyniki i nie chcesz ryzykować dużych strat.

7. Zbierz i przeanalizuj wyniki

Po zakończeniu testu Twoje narzędzie A/B (np. Google Optimize) pokaże metryki typu:

- Konwersja i wzrost/spadek względem wersji kontrolnej,

- Istotność statystyczna,

- Liczba użytkowników i transakcji w obu wariantach.

Jeśli wariant B osiągnął znacząco lepszy wynik (np. wyższa konwersja, a p-value < 0,05), możesz uznać, że zmiana przynosi korzyści. Wdrożenie zmiany na stałe w sklepie to kolejny krok – warto jednak nadal monitorować, czy efekt utrzymuje się w dłuższej perspektywie.

Gdy brak wyraźnej różnicy między wariantami, nie oznacza to całkowitej porażki. Może się okazać, że testowana zmiana nie jest istotna dla klientów lub jest niewidoczna. Trzeba wtedy szukać innych obszarów do optymalizacji albo wdrożyć bardziej znaczącą modyfikację.

8. Dokumentuj wnioski i wprowadzaj je w życie

Każdy test A/B powinien być starannie udokumentowany:

- Jaką hipotezę testowano,

- Jakie były warianty,

- Wielkość próby, długość testu,

- Wyniki i wnioski.

Dzięki temu z czasem stworzysz bazę wiedzy, do której będziesz wracać przy projektowaniu dalszych ulepszeń. Wnioski z jednego testu mogą wskazać kierunki kolejnych eksperymentów, tworząc ciągły cykl optymalizacji.

Co testować?

1. Strona główna

- Układ banerów, kolejność sekcji, typ grafiki w sliderze,

- Główne CTA (np. „Sprawdź nowości” vs. „Kup teraz”),

- Komunikaty o darmowej dostawie czy rabatach,

- Nawigacja i menu (pionowe, poziome, rozwijane).

2. Karta produktu

- Tytuł produktu (zwięzły vs. rozbudowany),

- Lokalizacja i kolor przycisku „Dodaj do koszyka”,

- Prezentacja ceny (np. wyeksponowanie oszczędności, przekreślona cena początkowa),

- Galeria zdjęć (liczba i układ miniatur),

- Użyteczność kluczowych informacji (dostawa, termin realizacji, rozmiar, recenzje).

3. Koszyk i checkout

- Jednostronicowy vs. wieloetapowy proces,

- Wyraźne prezentowanie kosztów wysyłki,

- Formy płatności i szybkość ich wyboru,

- Usunięcie zbędnych pól w formularzu (np. dane do faktury tylko na życzenie).

4. Pop-upy i banery promocyjne

- Treść, design i moment wyświetlenia (np. po 10 s od wejścia?),

- Rabat przy zapisie do newslettera vs. brak rabatu,

- Okienko przypominające o porzuconym koszyku,

- Propozycje cross-sellingu/upsellingu w czasie zakupów.

5. Elementy zaufania

- Recenzje i ratingi (np. widgety z opiniami),

- Ikony zaufania (np. certyfikaty bezpieczeństwa, pieczęcie jakości),

- Sekcja „O nas” – rozbudowana vs. minimalistyczna,

- Informacja o polityce zwrotów i dostawy w widocznym miejscu.

Praktyczne przykłady liczbowych efektów testów A/B

- Zmiana koloru przycisku „Dodaj do koszyka”

- Wariant A (kontrolny): przycisk w kolorze zielonym; konwersja 2%.

- Wariant B (eksperymentalny): przycisk w kolorze pomarańczowym (bardziej kontrastowym); konwersja 2,2%.

- Wzrost konwersji o 10% (relatywnie), przy statystycznej istotności 95% i odpowiedniej próbie (np. 20 tys. użytkowników).

- Prosty vs. rozbudowany formularz zamówienia

- Wariant A: 3 kroki checkoutu (dane do wysyłki, wybór metody dostawy, podsumowanie), konwersja 1,8%.

- Wariant B: 1 strona checkoutu, wszystkie informacje na jednym ekranie, konwersja 2%.

- Różnica 0,2 p.p. może wydawać się niewielka, ale to 11% poprawa w konwersji. Przy 10 000 odwiedzin dziennie może oznaczać dziesiątki dodatkowych transakcji tygodniowo.

- Porzucone koszyki a informacja o czasie dostawy

- Wariant A: Brak wyeksponowanej informacji, że przesyłka dotrze w 24h, konwersja w koszyku 40%.

- Wariant B: Duży baner „Zamów dziś – wysyłka w 24h”, konwersja w koszyku 45%.

- Wzrost konwersji w samym koszyku o 5 punktów procentowych = mniejszy odsetek porzuceń.

Najczęstsze błędy w testach A/B

- Testowanie zbyt wielu elementów naraz

Jeżeli zmieniasz kolor przycisku, układ strony i zawartość opisów jednocześnie, trudno ustalić, która modyfikacja wpłynęła na wynik. Lepiej dzielić zmiany na kilka pojedynczych testów. - Kończenie testu za wcześnie

Wiele osób, widząc obiecujące wyniki w ciągu 2–3 dni, przerywa test. Jednak krótkotrwałe wahania mogą nie oddawać długofalowej tendencji. Poczekaj, aż osiągniesz niezbędną liczbę użytkowników oraz stabilną istotność statystyczną. - Brak jasnej hipotezy

Jeśli nie masz konkretnego uzasadnienia, dlaczego zmiana mogłaby podnieść konwersję, istnieje ryzyko, że test będzie przypadkowy i trudny w interpretacji. - Lekceważenie sezonowości i innych czynników zewnętrznych

Gwałtowny wzrost sprzedaży może wynikać z okresu świątecznego, a niekoniecznie z wprowadzanej zmiany. Staraj się prowadzić testy w miarę stabilnym okresie lub porównywać analogiczne okresy czasu. - Niewłaściwa segmentacja użytkowników

Różne grupy klientów (np. stali bywalcy vs. nowi) mogą inaczej reagować na zmiany. Może się okazać, że ogólnie nie widać różnicy, ale w segmencie nowych użytkowników jest duży wzrost konwersji.

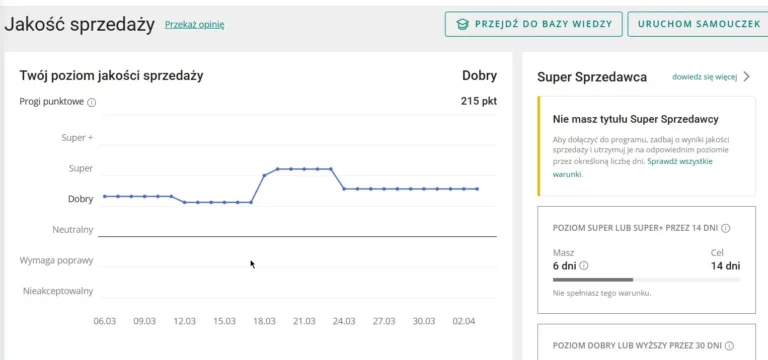

Jak utrwalić efekty testów A/B: ciągła optymalizacja

Testy A/B powinny być elementem ciągłej praktyki optymalizacji w e-commerce. Po wdrożeniu korzystnych zmian warto obserwować, czy efekt się utrzymuje. Co jakiś czas można też odświeżać look & feel czy funkcjonalności, bo trendy się zmieniają, a klienci przyzwyczajają się do pewnych rozwiązań.

Najlepsze marki e-commerce (np. Amazon, Zalando) nieustannie prowadzą dziesiątki, jeśli nie setki testów jednocześnie. Być może Twój sklep nie ma takiej skali, ale idea pozostaje ta sama – małe usprawnienia, wprowadzane metodycznie, mogą kumulować się w znaczny wzrost przychodów w ciągu kilku miesięcy.

Czy warto testować?

Testy A/B w sklepie internetowym to jedno z najpotężniejszych narzędzi do podnoszenia konwersji, poprawiania UX i zwiększania ogólnej zyskowności. Ich główną zaletą jest obiektywność – decyzje nie opierają się wyłącznie na intuicji, lecz na twardych danych o realnych zachowaniach klientów.

Najważniejsze wskazówki, które warto zapamiętać:

- Zdefiniuj cel i hipotezę – wiesz, co chcesz poprawić i dlaczego.

- Skupiaj się na jednym kluczowym elemencie w danym teście, aby móc wyciągnąć klarowne wnioski.

- Zadbaj o wystarczającą próbę i czas trwania testu, by wyniki były wiarygodne statystycznie.

- Dokumentuj i analizuj – zapisuj, co testowałeś, z jakim skutkiem. Korzystaj z tych informacji przy kolejnych eksperymentach.

- Stawiaj na ciągłą optymalizację – e-commerce jest dynamiczne, a testy A/B to stały element rozwoju Twojego biznesu.

Dzięki świadomie i dobrze prowadzonym testom A/B możesz odkryć ukryty potencjał swojej strony: poprawić doświadczenie klientów, skrócić ścieżkę zakupową i maksymalnie wykorzystać każdy odwiedzinę, zamieniając ją w transakcję. Pamiętaj, że nawet niewielkie ulepszenia potrafią przełożyć się na realny wzrost sprzedaży w długiej perspektywie. Kluczem do seukcesu jest też wyciąganie wniosków z testów. Dodatkową przeszkodą, o której rzadko się mówi jest sam proces wdrożenia poprawek, który czasami jest najtrudniejszy w całym procesie.