Co to jest algorytm wyszukiwania?

W skrócie:

- 1 Co to jest algorytm wyszukiwania?

- 2 Składniki Algorytmu Wyszukiwania Google

- 3 Aktualizacje Algorytmu Google: Ewolucja Wyszukiwania w Internecie

- 3.1 1. Panda (2011)

- 3.2 2. Penguin (2012)

- 3.3 3. Hummingbird (2013)

- 3.4 4. Mobilegeddon (2015)

- 3.5 5. RankBrain (2015)

- 3.6 6. BERT (2019)

- 3.7 Wyróżnia się trzy podstawowe rodzaje kar od Google:

- 3.8 Zmiany w algorytmach Google: Panda i Pingwin

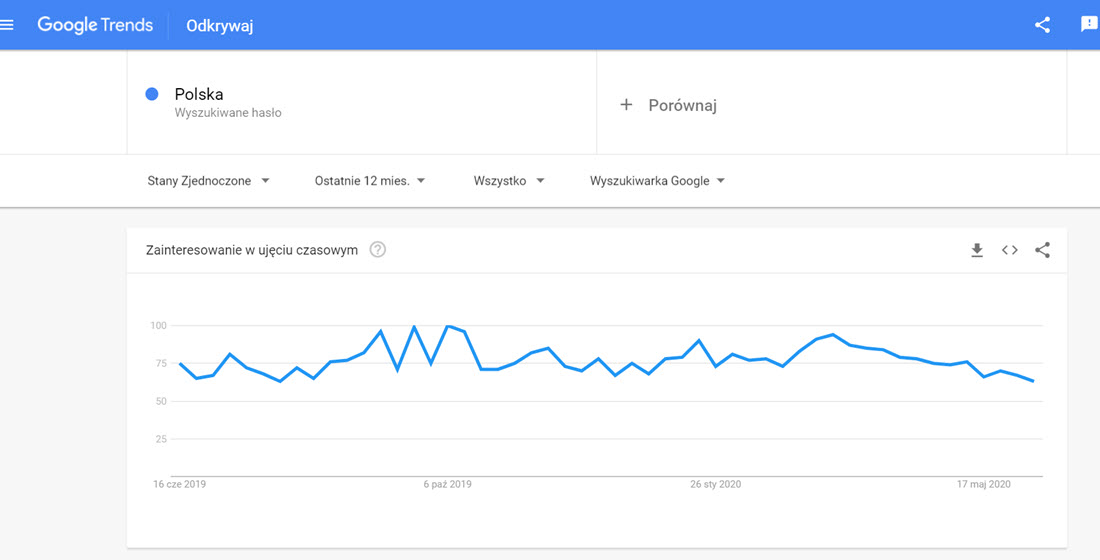

- 3.9 Historia zmian w Google

- 3.10 Różnorodność wyników

- 3.11 Autorytet strony w rankingu

- 3.12 Wpływ jakości treści na pozycję strony

- 4 Algorytm z południa – Pingwin

- 5 Jest kara, nie ma kary

W erze cyfrowej większość z nas korzysta z wyszukiwarek internetowych, takich jak Google, by znaleźć odpowiedzi na pytania, które nas nurtują. Ale jak dokładnie działają algorytmy tej wyszukiwarki? Zajrzyjmy w głąb tajemniczej maszynerii.

Składniki Algorytmu Wyszukiwania Google

Google jest najpopularniejszą wyszukiwarką na świecie, a jej algorytm jest kluczem do jej sukcesu. W rzeczywistości algorytm Google jest niesamowicie złożony i składa się z setek, jeśli nie tysięcy czynników, które wspólnie decydują o tym, które strony pojawiają się na czele wyników wyszukiwania. Chociaż pełne szczegóły są tajemnicą handlową, możemy zrozumieć ogólny obraz, badając główne składniki algorytmu.

1. Ranking

Ranking jest sercem algorytmu Google. W skrócie, decyduje, które strony są najbardziej istotne dla danego zapytania.

- Jakość treści: Google dąży do zapewnienia użytkownikom najbardziej wartościowych informacji. Aby to osiągnąć, ocenia jakość treści na stronie. Czynniki takie jak oryginalność, głębokość analizy i użyteczność treści są kluczowe.

- Linki: Jak już wspomniano, Google korzystał pierwotnie z systemu PageRank, który opierał się na linkach. Chociaż algorytm ewoluował, linki wciąż odgrywają kluczową rolę. Wskaźniki, takie jak liczba linków prowadzących do strony oraz jakość tych linków, mają duży wpływ na ranking.

- Historia przeglądania: Google uwzględnia również interakcje użytkownika z różnymi stronami. Jeśli użytkownik często odwiedza konkretną stronę lub spędza na niej dużo czasu, może to wpłynąć na ranking tej strony dla tego użytkownika.

2. Analiza zapytania

Kiedy użytkownik wpisuje zapytanie w Google, nie szuka tylko słów kluczowych. Szuka odpowiedzi. Dlatego Google analizuje zapytanie w kontekście, aby zrozumieć, czego użytkownik naprawdę szuka.

- Słowa kluczowe: Algorytm ocenia, które słowa w zapytaniu są najważniejsze i jakie mają znaczenie w kontekście całego zapytania.

- Intencja zapytania: Google stara się zrozumieć, czego użytkownik naprawdę chce. Czy szuka informacji? Czy chce coś kupić? A może chce odwiedzić konkretną stronę?

3. Filtrowanie i personalizacja

W dobie mediów społecznościowych i big data personalizacja stała się kluczem do sukcesu wielu platform online. Google nie jest wyjątkiem.

- Historia przeglądania: Google analizuje Twoją historię przeglądania, aby dostosować wyniki wyszukiwania do Twoich indywidualnych zainteresowań.

- Lokalizacja: Twoja lokalizacja może mieć ogromny wpływ na to, co pojawia się w wynikach wyszukiwania. Na przykład, jeśli szukasz „restauracji w pobliżu”, Google dostarczy Ci wyniki bazujące na Twojej obecnej lokalizacji.

- Inne dane: Google może uwzględniać również inne dane, takie jak urządzenie, z którego korzystasz, czy też dane z innych usług Google, które używasz.

Aktualizacje Algorytmu Google: Ewolucja Wyszukiwania w Internecie

Algorytm Google to serce tej globalnej wyszukiwarki, a jego regularne aktualizacje odzwierciedlają ciągłe dążenie firmy do doskonałości w dostarczaniu najbardziej trafnych i użytecznych wyników użytkownikom. Oto przegląd najważniejszych aktualizacji, które wpłynęły na świat SEO i doświadczenia użytkowników.

1. Panda (2011)

Cel: Nagradzanie wysokiej jakości treści i karanie niskiej jakości.

Wprowadzenie aktualizacji Panda miało na celu karanie stron o niskiej jakości treści oraz „chudej” zawartości. Po tej aktualizacji strony, które generowały duże ilości niskiej jakości treści w celu zdobycia ruchu, zaczęły tracić w rankingach.

2. Penguin (2012)

Cel: Walka z nadmierną optymalizacją i sztucznymi linkami.

Penguin został wprowadzony, aby zidentyfikować i ukarać strony, które manipulowały rankingiem poprzez nieuczciwe techniki linkowania. Strony stosujące takie techniki jak zakup linków czy nadmierne linkowanie wewnętrzne były karane.

3. Hummingbird (2013)

Cel: Lepsze zrozumienie zapytań użytkowników.

Hummingbird skupił się na zrozumieniu intencji za zapytaniami, a nie tylko na dosłownych słowach kluczowych. Pozwoliło to Google na dostarczanie bardziej trafnych wyników, zwłaszcza w przypadku skomplikowanych zapytań.

4. Mobilegeddon (2015)

Cel: Poprawa doświadczenia użytkowników mobilnych.

W odpowiedzi na rosnącą liczbę użytkowników mobilnych, Google wprowadził aktualizację, która promowała strony zoptymalizowane pod kątem mobilności. Strony, które nie były przyjazne dla urządzeń mobilnych, miały obniżony ranking w wynikach wyszukiwania na smartfonach.

5. RankBrain (2015)

Cel: Zastosowanie sztucznej inteligencji w wyszukiwaniu.

RankBrain to system oparty na sztucznej inteligencji, który pomaga Google interpretować zapytania użytkowników i dostarczać bardziej trafne wyniki. Jest to kluczowy składnik algorytmu Google i jego rola stale rośnie.

6. BERT (2019)

Cel: Lepsze zrozumienie kontekstu zapytań.

BERT (Bidirectional Encoder Representations from Transformers) to technika przetwarzania języka naturalnego, która pozwala Google lepiej zrozumieć kontekst zapytania. Dzięki BERT, Google może lepiej rozumieć złożone zapytania i dostarczać bardziej trafne wyniki.

Wyróżnia się trzy podstawowe rodzaje kar od Google:

- kary ręczne,

- kary algorytmiczne,

- kary rankingowe.

Zmiany w algorytmach Google: Panda i Pingwin

Historia zmian w Google

- 02.2011 Panda 1.0 – pierwsze wdrożenie algorytmu Panda. Kary nałożone na ogromną liczbę stron o bardzo słabej jakości;

- 06.2011 Panda 2.2 – Google wypowiada wojnę automatycznie generowanym treściom. Zmiana o dużym wpływie;

- 11.2011 Panda 3.1 – rozpoczęcie wprowadzania częstych aktualizacji i zmiana w algorytmie. Wszystko, by szybciej reagować na zmiany w sieci;

- 01.2012 – tak zwany Top Heave Update. Walka ze zbyt dużą ilością reklam w okolicach początku strony. Algorytm karał za umieszczanie reklam (także w programie AdSense) w górnej części witryny. By ustrzec się przed konsekwencjami należało je ograniczyć, lub umieścić w innych, niestety nieco mniej eksponowanych, miejscach;

- 02.2012 Panda 3.3 – zwiększenie precyzji oceny przez algorytm;

- 03.2012 Panda 3.4 – zmiana w systemie ocen. Dotknięte zmianą 1,6% witryn;

- 07.2012 Panda 3.9 – aktualizacja algorytmu Google, która spowodowała silne wahania wyników przez około tydzień. Zmiany według Google dotyczyły ok. 1% zapytań;

- 08.2012 Update przeznaczony do walki z piractwem internetowym, czyli kradzieżą lub nielegalnym wykorzystywaniem cudzych treści. Surowe kary były wymierzane stronom, co do których napływały zgłoszenia od użytkowników o piractwie. Główne kontrowersje dotyczyły sytuacji, gdy właściciel konkurencyjnej strony zgłaszał złośliwie stronę rywala. Powodowało to przedłużanie się procesu weryfikacji stron i zawieszenie w rankingu;

- 09.2012 – Zmiana wycelowana w zniwelowanie przewagi stron, których adres odpowiadał dokładnym wyszukiwaniom. Przykładowo strona PizzeriaBydgoszcz.pl odpowiada dokładnemu dopasowaniu do wyszukania „pizzeria Bydgoszcz” i bez względu na jakość tej strony uzyskiwała przewagę nad innymi stronami o tej tematyce. Sytuację tę poprawiono;

- 12.2012 Panda Refresh – oficjalna zmiana update’u. 1,3% anglojęzycznych stron w obszarze zmian;

- 05.2014 Panda 4.0 – kolejna duża zmiana zarówno algorytmu jak i danych wejściowych do niego. W zależności od języka siła odczuwalnych zmian jest różna, ale dla języka angielskiego jest to ok. 7,5%;

- 09.2014 Panda 4.1 – podwyższenie wagi małych i średnich stron wyróżniających się dobrej jakości treścią. Możliwe się stało wybicie pomniejszych witryn przed duże marki. Około 4% stron objętych.

- Treść: wysokiej jakości, przydatna, unikalna, przejrzysta (brak przeładowania reklamami). Duża zawartość wiedzy fachowej, autorskich analiz, twórczych opracowań. Treść nie może być generowana maszynowo, kopiowana z innych witryn, nie może być krótka i „o niczym”. Treść musi wnosić coś nowego – nowy punkt widzenia na dany temat, lub twórcze zestawienie wielu punktów widzenia. Treści powinny być w miarę potrzeby aktualizowane – to także zwiększa ich przydatność.

- Struktura strony: przydatność i autorytet strony potwierdzony licznymi linkami do niej zarówno zewnętrznymi jak i wewnętrznymi. Im więcej przekierowań z uznanej marki serwisów, tym lepiej. Pochlebne opinie z różnych źródeł – fora internetowe, serwisy o dużym zasięgu, komentarze, testy. Nagłówki, obrazy i inne multimedia muszą odpowiadać treściom na stronie.

- Reklamy: nie przeszkadzające w przeglądaniu treści, niebanalne. Na stronie nie powinno się znajdować zbyt wiele słów kluczowych.

- Podstawowe grzechy przeciwko Pandzie.

- Algorytm Panda został wdrożony w celu poprawy zawartości internetu. Wymieńmy zatem podstawowe błędy przy zarządzaniu stronami internetowymi, które mogą powodować nakładanie przez Google kar i lub pogorszenie pozycji rankingowej:

- Krótka treść – przykładowo strona z opisami książek, gdzie każdej z nich poświęcono po kilka zdań. Wkład informacyjny takiej strony jest mizerny i tak też będzie oceniana przez algorytm Panda.

- Kopiowana treść – treści skopiowane, lub przeniesione z niewielkimi zmianami z innych serwisów. Z punktu widzenia wyszukiwarki nie ma potrzeby serwować użytkownikowi takiej strony, skoro można mu pokazać stronę z oryginalnymi tekstami – na pewno będzie to z większym pożytkiem dla wyszukującego.

- Niska oryginalność treści – nawet jeśli zamieszczamy wykreowane przez nas samych treści, to wcale nie znaczy, że nasza strona znajdzie się na czołowych pozycjach w wynikach wyszukiwania. Google nisko ocenia kolejną stronę na temat „wałkowany” przez milion innych witryn. Nawet jeśli wnosi ona sporo nowego. Twórzmy dobre strony na tematy rzadkie, a na pewno odniesiemy rankingowy sukces.

- Treść niskiej jakości – dbajmy o przestrzeganie zasad ortografii na naszych stronach, a także o brak literówek. Są to proste wskaźniki niskiej staranności twórcy i mogą świadczyć o niskim jej profesjonalizmie.

- Farmy treści – strony zawierające mnóstwo podstron, ale na każdej z nich treści są bardzo zbliżone do siebie tematycznie. Google walczy z tworzeniem treści „o niczym”. Przykładem jest serwis publikujący informacje o traktorach, który zawiera podstrony o „przydatności traktorów”, „potrzebie traktorów”, „budowie traktorów”, „działaniu traktorów”, „wyższości traktorów nad stosowaniem koni” i tak dalej. Wszystko na praktycznie jeden temat, strona nastawiona na ruch sieciowy bez wkładu w tworzenie „dobrego” internetu.

- Treść generowana automatycznie – opisy produktów w sklepie internetowym wygenerowane skryptowo. Treść mało unikalna, powtarzalna, bez wkładu człowieka.

Różnorodność wyników

Autorytet strony w rankingu

Wpływ jakości treści na pozycję strony

Kiepska treść? Działaj!

Jak długo trwa zniesienie kary?

- bogata, przydatna i wartościowa treść,

- duży autorytet strony,

- dobra o niej opinia użytkowników, internautów,

- autorskie analizy i opracowania,

- duży komfort przeglądania witryny,

- jasny, czytelny układ strony, nie zaśmiecony reklamami,

- brak wielokrotnie używanych fraz kluczowych.

Algorytm z południa – Pingwin

- Pingwin 1.0 – 24.04.2012 – narodziny Pingwina.

- Pingwin 1.1 – 25.05.2012 – aktualizacja polegająca na wypowiedzeniu wojny stronom przejściowym (tak zwane door pages). Zmiany ominęły Polskę.

- Pingwin #3 – 05.10.2012 – zmiana o niewielkim (około 0,3%) wpływie.

- P ingwin 2.0 – 22.05.2013 – szumnie zapowiadana zmiana w rzeczywistości nie miała aż tak wielkiego wpływu na wyszukiwanie jaki jej wróżono. Intencją jej było jeszcze bardziej dokładne ocenianie profili linkowych. Zmiana rozpoczęła ocenianie na niższym poziomie struktury – z dokładnością do podstrony.

- Pingwin 2.1 – 4.10.2013 – zapowiadany wpływ (poniżej 1% stron objętych) okazał się być znacznie większy. Google nie podał na czym dokładnie polegała ta modyfikacja.

- Pingwin 3.0 – 17.10.2014 – nowa wersja algorytmu. Zrefaktorowano cały kod, główne funkcjonalności nie podlegały jednak większym zmianom. Przy okazji przepisania algorytmu poprawiono jego wydajność i pomniejsze błędy.

- Pingwin 3.1 – 27.11.2014 – nie potwierdzona aktualizacja

- Pingwin 3.2 – 02.12.2014 – niewielka zmiana o niewielkim wpływie, nie została potwierdzona przez Google.

- Pingwin 3.3 – 05.12.2014 – mała modyfikacja, ale o zauważalnych skutkach.

- Pingwin 3.4 – 06.12.2016 – kolejna niepotwierdzona oficjalnie zmiana.

- Pingwin 4.0 – 23.09.2016 – dwa lata po ostatniej oficjalnie ogłoszonej aktualizacji, ta jest następna. Przede wszystkim algorytm stał się elementem głównego algorytmu, dzięki czemu nie trzeba czekać na jego odświeżenie, by odczuć jego wpływ na oceny. Działa teraz w czasie rzeczywistym (real-time). Wszystkie kolejne poprawki mają być wprowadzane sukcesywnie w miarę zaistnienia potrzeby, bez uprzedniego powiadamiania. Algorytm działa na jeszcze niższym poziomie struktury.

Priorytety algorytmu Penguin

- Article folder – strony linkowane przez tak zwane katalogi linków, których niemal jedyną zawartością są linki do innych stron będą brane pod lupę przez algorytm Pingwin. Na podstawie analizy zebranych danych Google uznało, że istnieje dość silna korelacja między linkowaniem z takich linkowych hubów, a kiepską treścią.

- Yellow pages – linkowanie z katalogów stron może także nie być opłacalne. Należy wystrzegać się mało znanych i uznawanych katalogów, by nie zostać posądzonym przez Google o posiadanie linków niewiarygodnych. Tylko nieliczne katalogi cieszą się uznaniem Google. Są to między innymi Yahoo!, Business.com i nieliczne lokalne takie jak panoramafirm.pl, zumi.pl i tym podobne.

- Frazy kluczowe – wielokrotne używanie tej samej frazy kluczowej prowadzącej do tej samej lokalizacji jest zdecydowanie podejrzana dla Pingwina. Algorytm może traktować taką praktykę jako spamowanie. Wystrzegaj się zatem nadużywania słów kluczowych, a już na pewno staraj się, by prowadziły w różne miejsca twojej witryny. Oczywiście może się zdarzyć, że będziesz chciał podlinkować pewną lokalizację w kilku miejscach, ale pilnuj, by nie weszło ci to w krew. Nałożenie kary przez algorytm Pingwin może być dużo bardziej dotkliwe niż Pandy, ze względu na czas jej zniesienia.

- Linki z innych krajów – oficjalnie nie zostało potwierdzone, że linki pochodzące z serwisów znajdujących się daleko poza granicami kraju pochodzenia witryny naruszają zasady algorytmu Pingwin. Miej jednak na uwadze, że z punktu widzenia Google może to być uważane za spam. Istnieje bowiem niewielka szansa, że sprzedając buty zimowe, link ze strony z Urugwaju prowadzący na twoją witrynę jest wiarygodnym wyrażeniem użyteczności twojej strony w tamtym rejonie świata. W Urugwaju temperatura rzadko zbliża się do +10 stopni Celsjusza!

- Spamowanie na forach – nadmierna ilość bezpośrednich linków na twoją stronę pochodzących z różnego rodzaju komentarzy, postów, forów dyskusyjnych może wskazywać na szeroko zakrojoną kampanię spamerską i wzmóc czujność algorytmu.

Jest kara, nie ma kary

- usunięcie niepożądanych linków,

- uzbrojenie się w cierpliwość.